Emerson Network Power analizza le tendenze di sviluppo dei data center e indica i quattro archetipi in progressiva affermazione che ne ridefiniranno l’aspetto e l’operatività futura.

Dai trasporti alla sanità e al retail, forze destabilizzanti determinano sfide e opportunità praticamente per tutti i settori. Il data center, che in molti casi è agente di destabilizzazione, non fa eccezione. Tale destabilizzazione proviene da forze esterne e pressioni interne che mettono in discussione i paradigmi operativi e hanno le potenzialità per creare nuovi archetipi di data center.

L’archetipo aziendale oggi dominante è il data center a elevata disponibilità, con alimentazione 2N, generatori ridondanti e condizionamento. La maggior parte delle imprese hanno aggiunto una qualche forma di Software-as-a-Service (SaaS) alla loro architettura IT, e stanno valutando o adottando sempre di più un’architettura bimodale che riconosce che applicazioni, tipi di dati e gruppi di utenti diversi hanno esigenze diverse in termini di velocità di implementazione, produttività, efficienza, flessibilità e sicurezza. Inoltre, l’open computing e il data center basato sul software hanno il potenziale per modificare il modo in cui i sistemi IT sono configurati e supportati.

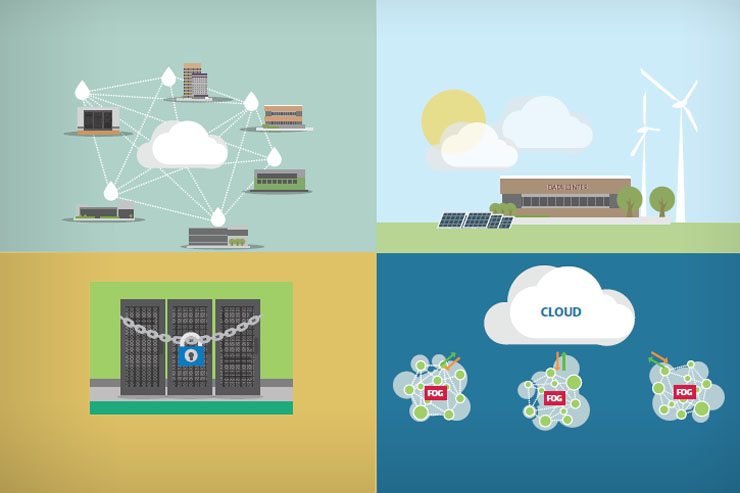

Il passaggio al bimodale non è l’unico esempio di archetipo che si sta affermando. Ecco altri quattro archetipi di data center che i nostri clienti stanno esplorando.

Le inefficienze del cloud computing

L’attuale realtà del cloud computing è che molte imprese stanno acquistando capacità di elaborazione, principalmente attraverso configurazione SaaS, per mettere online le applicazioni più rapidamente e a un costo inferiore, in un momento in cui le risorse informatiche interne sono sottoutilizzate. La virtualizzazione avrebbe dovuto risolvere il problema delle basse percentuali di utilizzo dei server, e ha sortito qualche effetto, tuttavia uno studio del 2015 di Jonathan Koomey di Stanford e Jon Taylori di Anthesis Group, ha rilevato che i server dei data center continuano a fornire in media soltanto dal 5 al 15% della loro capacità massima di elaborazione nel corso di un anno. Lo studio ha rilevato inoltre che il 30% dei server fisici risultano “comatosi” ossia non hanno fornito servizi di elaborazione in sei mesi o più.

In un periodo in cui il modello di “servizio condiviso” viene applicato a tutto, dal servizio di taxi personale ai consulenti legali, il progetto di una piattaforma tecnologica che consenta alle imprese di sfruttare questa capacità inutilizzata on-demand e di vendere la capacità in eccesso sul mercato libero, non dovrebbe tardare a concretizzarsi. Questo approccio ai servizi condivisi potrebbe determinare un maggior utilizzo dei server aziendali, allungare la vita dei data center esistenti che vanno verso un modello di autosufficienza, e offrire alle aziende la capacità di costruire nuovi data center sulla base della domanda media e non di picco.

Il data center conforme alla responsabilità sociale d’impresa

Il settore si occupa della sfida dell’efficienza almeno dal 2007, ma focalizzandosi per lo più sull’aspetto finanziario. Adesso, con il consumo energetico del settore che continua ad aumentare e a richiamare maggior attenzione, alcune aziende stanno valutando in che modo i data center rientrano nei loro progetti di sostenibilità. Questa focalizzazione sulla sostenibilità sta elevando il profilo di problematiche come le emissioni di CO2, l’uso di energia alternativa e lo smaltimento responsabile. Per essere significativo, l’approccio deve interessare l’intero sistema del data center, compresi i fornitori di servizi di colocation e cloud computing.

Queste aziende adotteranno un approccio più aggressivo all’efficienza del data center — utilizzando per esempio sistemi di condizionamento con la massima economizzazione e UPS con inverter attivi che passano in modo semplice e rapido dalla modalità ECO a quella ad alta efficienza — spingendo anche per un maggior utilizzo di energia alternativa, come l’eolico e il solare, per alimentare le attività del data center e ridurre le emissioni di carbonio. Alla luce di questa tendenza, la previsione effettuata dai partecipanti all’iniziativa Data Center 2025 secondo la quale l’energia solare rappresenterebbe il 21% dell’energia del data center entro il 2025, che è sembrata estremamente aggressiva ad alcuni esperti, potrebbe rivelarsi precisa.

La fortezza dei dati

Il costo e la frequenza delle violazioni dei dati continua ad aumentare, malgrado i miliardi spesi ogni anno per la sicurezza digitale. Lo studio del Ponemon Institute Cost of Data Breach indica un incremento del 23% del costo di una violazione della sicurezza dei dati correlata alla privacy negli ultimi due anni, con un costo totale attestato attualmente a 3,8 milioni di dollari. Inoltre, uno studio del Ponemon sul tempo di fermo del data center commissionato da Emerson Network Power ha rilevato che il numero di episodi di fermo correlati alla sicurezza è aumentato dal 2% del 2010 al 22% del 2015. Il costo e la frequenza aumentano al punto che alcune aziende sono costrette ad adottare un approccio alla progettazione del data center che dia priorità alla sicurezza. In una certa misura questa tendenza è già in atto poiché aziende dei settori medico, industriale, farmaceutico e aerospaziale stanno implementando architetture POD all’interno o adiacenti ai data center esistenti specificatamente per gestire i dati sensibili. L’ondata successiva è rappresentata dalla struttura di archiviazione offline (cold-storage) costruita appositamente con enormi sistemi di archiviazione protetti da ingenti investimenti in sistemi di sicurezza e protetti dall’accesso di tutte le reti tranne quelle autorizzate. Le strutture di colocation offrono attualmente “suite sicure” con apparecchiature energetiche e termiche dedicate, invece degli ambienti “open-caged” (a gabbia aperta) che sono stati la norma, per migliorare la sicurezza fisica delle loro strutture.

Fog Computing

Il fog computing è un’architettura informatica distribuita promossa da Cisco in risposta all’Internet delle cose (IoT, Internet of Things). Simile nella filosofia ai micro data center ora implementati all’estremità della rete per offrire un accesso più rapido ai contenuti e alle applicazioni, il fog computing collega molteplici reti di piccole dimensioni dei sistemi industriali in una grande rete interaziendale. Nel fog, i servizi applicativi sono distribuiti tra dispositivi intelligenti e micro data center per migliorare l’efficienza e concentrare l’elaborazione dei dati in modo che vengano trasmessi soltanto i dati utili. Questo approccio offre un metodo più efficiente ed efficace per trattare l’immensa quantità di dati generati dai sensori che costituiscono l’Internet delle cose e permette inoltre di aggregare e filtrare i dati localmente per preservare la larghezza di banda per i dati utili.

Velocità, costo, sicurezza, sostenibilità, disponibilità delle applicazioni e produttività sono tutti fattori di cui gli operatori di data center dovranno tenere conto nei futuri archetipi per far fronte ai disturbi che si presentano dentro e fuori dalla loro azienda.

Alcuni segmenti del mercato sono dominati principalmente da una forza destabilizzante, come la sicurezza o la sostenibilità, per creare questi archetipi emergenti. La maggior parte dei gestori di data center dovranno tuttavia destreggiarsi tra le esigenze contrastanti di molteplici proprietari di applicazioni o tentare di soddisfare i proprietari delle applicazioni che esigono tutte le caratteristiche elencate in precedenza. La gestione definita da software offrirà sempre più la flessibilità di cui le aziende hanno bisogno per allontanarsi dai data center a “singola istanza” in cui tutti i dati e le applicazioni sono trattati con lo stesso livello di flessibilità e sicurezza adottando nuove tecnologie e prassi sperimentate per la prima volta negli archetipi di data center.

Questo permetterà alle aziende di evolvere all’ecosistema del data center del futuro capace di soddisfare tutte queste tendenze destabilizzanti attraverso un modello multi-modale in cui l’ambiente è confezionato su misura per le esigenze specifiche dei dati, delle applicazioni e degli utenti che supporta. Collaborando con i proprietari delle applicazioni per soddisfarne le esigenze specifiche, i gestori di data center avranno l’opportunità di sfruttare il loro ruolo di fornitori di servizi per diventare consulenti fidati.