NetApp incontra la stampa di settore e presenta le NetApp 2019 Perspectives: non solo tecnologie per il futuro ma anche e soprattutto per il presente.

NetApp presenta, come di consueto, le sue vision per l’anno che inizia. È Roberto Patano, senior manager solution engineering, ad affrontare le riflessioni stilate dal CSO di NetApp, Atish Gude. Ed è proprio questo, il primo grande cambiamento: L’interlocutore non è più il CTO, come sarebbe lecito attendersi. Oggi, NetApp (e in senso lato il mercato tutto) si relaziona con i CSO, i Solution Officer.

Roberto Patano ha anche più volte rimarcato un ulteriore cambio di passo, nelle Perspectives 2019: se in passato NetApp parlava di previsioni, oggi si tratta di tendenze già in corso; il manager italiano ha detto che anche in Italia (per fortuna) c’è fermento e voglia di rimettere in molto la locomotiva tecnologica. Oggi, business e tecnologia sono profondamente collegati, ancor più di quanto non lo fossero in passato.

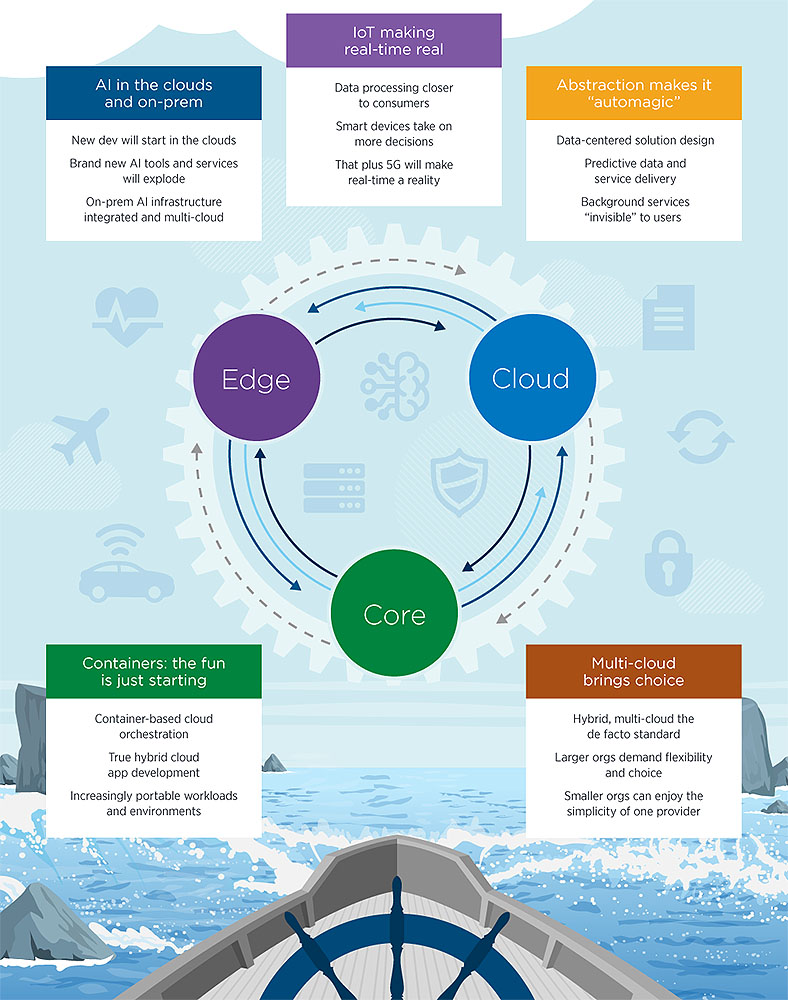

Possiamo citare alcune tematiche che ricorrono: l’intelligenza artificiale, che sarà sempre più applicata e che troverà ampi spazi nello sviluppo, nella gestione dei dati, e ovviamente di applicazioni e servizi edge, core e cloud. Patano ha anche affermato che, dopo un periodo comunque molto propositivo e progettuale, la containerizzazione è pronta al suo definitivo affermarsi come tecnologia abilitante.

Clicca per ingrandire

Un punto importante della presentazione del manager NetApp ha riguardato l’Internet of Things. I dispositivi IoT sono visti in grande aumento di potenza di calcolo; questo avrà una serie di effetti benefici. Da un lato, maggior potenza vuol dire maggior libertà di azione per gli sviluppatori, che avranno una gamma enorme di possibilità su cui contare.

Dall’altro, poter beneficiare di una potenza di elaborazione edge riduce i problemi legati alla banda larga, non sempre disponibile. Una risposta in real time sarà quindi possibile grazie alle capacità di calcolo dell’IoT stessa. Ovviamente, quando le reti 5G saranno realtà, saremo pronti per un ulteriore salto quantico.

Vediamo nel dettaglio quali sono le NetApp Predictions 2019, a cura di Atish Gude, Chief Stategy Officer di NetApp:

Vediamo nel dettaglio quali sono le NetApp Predictions 2019, a cura di Atish Gude, Chief Stategy Officer di NetApp:

L’AI si svilupperà rapidamente, soprattutto nel cloud – Ancora in una fase iniziale di sviluppo, le tecnologie AI elaboreranno enormi quantità di dati, la maggior parte dei quali sarà nei cloud pubblici.

Un numero in rapida crescita di software e strumenti di servizio per l’AI – principalmente nel cloud – renderà lo sviluppo dell’intelligenza artificiale sempre più facile. Questo consentirà alle applicazioni AI di offrire prestazioni elevate e scalabilità, sia on che off premise, e di supportare protocolli multipli di accesso ai dati e vari nuovi formati di dati. Di conseguenza, l’infrastruttura che supporta i carichi di lavoro AI dovrà anche essere veloce, flessibile e automatizzata. Mentre l’AI diventerà certamente il prossimo terreno di confronto per i fornitori di infrastrutture, la maggior parte dei nuovi sviluppi sarà rivolta al cloud.

IoT: i dispositivi troveranno la soluzione – I dispositivi Edge diventeranno più intelligenti e più capaci di prendere decisioni di elaborazione e applicazione in tempo reale.

I dispositivi Internet of Things (IoT) tradizionali sono stati costruiti attorno a un paradigma “phone home”: raccogliere dati, inviarli per l’elaborazione, attendere le istruzioni. Ma con l’avvento delle reti 5G, per prendere decisioni in tempo reale non si potrà aspettare che i dati facciano il giro su un cloud o un data center e tornino indietro; inoltre, la quantità dei dati disponibili sta aumentando a un tasso di crescita considerevole. Di conseguenza, l’elaborazione dei dati dovrà avvenire vicino al consumatore, con una maggiore capacità di elaborare i dati. I dispositivi e le applicazioni IoT – con servizi integrati come l’analisi e la semplificazione dei dati – diventeranno più veloci, efficienti e intelligenti nel decidere quali dati richiedono un’azione immediata, quali rimandare alla parte core o al cloud e persino quali dati scartare.

Automagically, please – La richiesta di servizi IT altamente semplificati determinerà la continua astrazione delle risorse IT e la trasformazione dei servizi di dati in commodity.

Ricordi quando le pubblicità per auto hanno iniziato a vantarsi del fatto che la tua prima messa a punto sarebbe stata a 100.000 chilometri? (Beh, alla fine è diventato abbastanza vero). Il punto è che quasi nessuno trascorre i fine settimana a cambiare il proprio olio o le proprie candele o ad aggiustare le cinghie di distribuzione. Tu accendi la macchina, e lei parte. Non devi pensarci finché non ricevi un messaggio che richiama la tua attenzione, è abbastanza semplice. Si stanno sviluppando le stesse aspettative per l’infrastruttura IT, a partire dallo storage e dalla gestione dei dati: gli sviluppatori non vogliono pensarci, vogliono solo che funzioni, “Automagicamente”, si spera. Soprattutto con le tecnologie di containerizzazione e “server-less”, la tendenza verso l’astrazione dei singoli sistemi e servizi guiderà gli architetti IT a progettare in funzione dei dati, a elaborarli, a creare data fabric ibridi e multi-cloud piuttosto che semplici data center. Con l’applicazione di tecnologie predittive e di diagnostica, i responsabili delle decisioni si affideranno sempre di più a servizi di dati estremamente solidi ma “invisibili”, che forniranno dati quando e dove necessari, ovunque essi risiedano. Queste nuove funzionalità automatizzeranno anche l’intermediazione dei servizi di infrastruttura come prodotti dinamici e la spola di container e workloads da e verso le soluzioni più efficienti dei service provider.

Il multi-cloud darà più scelta – Il cloud ibrido e multi-cloud sarà l’architettura IT predefinita per la maggior parte delle organizzazioni più grandi, mentre le altre sceglieranno la semplicità e la coerenza di un singolo cloud provider.

I container rendono i carichi di lavoro estremamente mobili. Ma i dati stessi possono essere molto meno portatili delle risorse di elaborazione e delle applicazioni e questo influenza la portabilità degli ambienti di runtime. Anche se si ha una soluzione per la data gravity, la coerenza dei dati, la loro protezione, la sicurezza e tutto il resto, è possibile dover affrontare il problema di una piattaforma di lock-in e di servizi specifici del cloud provider in cui i dati non possano essere del tutto trasferiti attraverso le diverse piattaforme cloud. Di conseguenza, le organizzazioni più piccole svilupperanno capacità interne come alternativa ai fornitori di servizi cloud, o sceglieranno la semplicità, l’ottimizzazione e la gestione hands-off derivante dall’acquisto da un unico cloud provider. È inoltre possibile fare affidamento sui service provider per sviluppare nuovi elementi distintivi per premiare chi sceglie il lock-in. D’altra parte, le organizzazioni più grandi richiederanno la flessibilità, la neutralità e l’economicità di poter spostare le applicazioni tra cloud diversi. Sfrutteranno container e data fabric per rompere il lock-in, per garantire la portabilità totale e per controllare il proprio destino. Qualunque sia il percorso che scelgono, le organizzazioni di tutte le dimensioni saranno chiamate a sviluppare politiche e pratiche per ottenere il massimo dalla loro scelta.

L’orchestrazione cloud basata su container consentirà lo sviluppo di applicazioni cloud ibrido – I container promettono, tra le altre cose, la libertà dal lock-in del fornitore. Mentre le tecnologie di containerizzazione come Docker continueranno ad avere rilevanza, lo standard de facto per lo sviluppo di applicazioni multi-cloud sarà Kubernetes. Le nuove tecnologie di orchestrazione cloud basate su container consentiranno lo sviluppo di applicazioni hybrid cloud, il che significa che verranno sviluppate nuove applicazioni per casi d’uso sia pubblici che on-premise: non più applicazioni di trasferimento da un ambiente all’altro. In questo modo sarà sempre più semplice spostare i carichi di lavoro verso il luogo in cui vengono generati i dati anziché il contrario.