Andrea Faeti, Sales Director Enterprise Accounts di Vertiv Italia, spiega come sia fondamentale un approccio unificato nella gestione dell’infrastruttura data center.

I sistemi di alimentazione e termici convergono in un’infrastruttura integrata progettata per rispondere ai requisiti di scalabilità, velocità e complessità dell’implementazione dell’AI nei data center ad alta densità

Il contesto

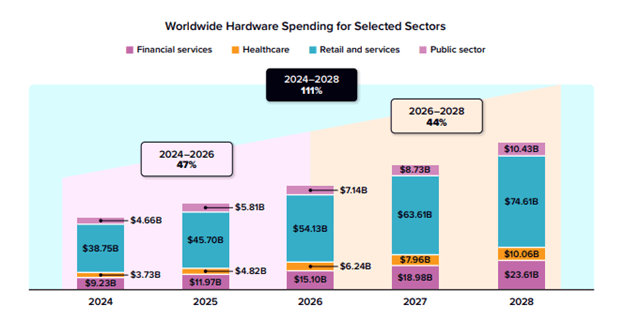

La progressiva complessità delle implementazioni ad alta densità evidenzia i limiti di un’infrastruttura frammentata. Secondo IDC, la spesa globale per l’hardware per AI dovrebbe raggiungere i 258 miliardi di dollari entro il 2028. (Grafico 1). Anche l’efficienza energetica dei data center è rilevante, con un consumo di energia che potrebbe più che raddoppiare entro il 2028. Questi cambiamenti accelerano la necessità di disporre di infrastrutture capaci di supportare implementazioni su scala ad alta densità e in tempi rapidi.

Grafico 1. La spesa mondiale per l’hw AI dovrebbe crescere del 111% dal 2024 al 2028 in tutti i settori chiave. Fonte: IDC, 2025

Gli operatori si trovano oggi a destreggiarsi in un contesto definito dall’aumento dei requisiti energetici dei rack, dalle dinamiche dei workload e dalle tempistiche ridotte per le implementazioni. Tuttavia, i sistemi di alimentazione e raffreddamento dei data center continuano a essere gestiti come funzioni separate, affidate a team, strumenti e fornitori diversi. Questa frammentazione introduce attriti in momenti in cui la velocità, l’uniformità e il coordinamento stanno diventando una priorità per le aziende.

In risposta a questa complessità, il rapporto tra le infrastrutture elettriche e termiche sta cambiando. L’integrazione dei sistemi aiuta a ridurre gli interventi di configurazione in loco, a minimizzare i rischi di implementazione e a supportare la gestione uniforme in tutte le sedi.

I costi nascosti derivanti dalla frammentazione

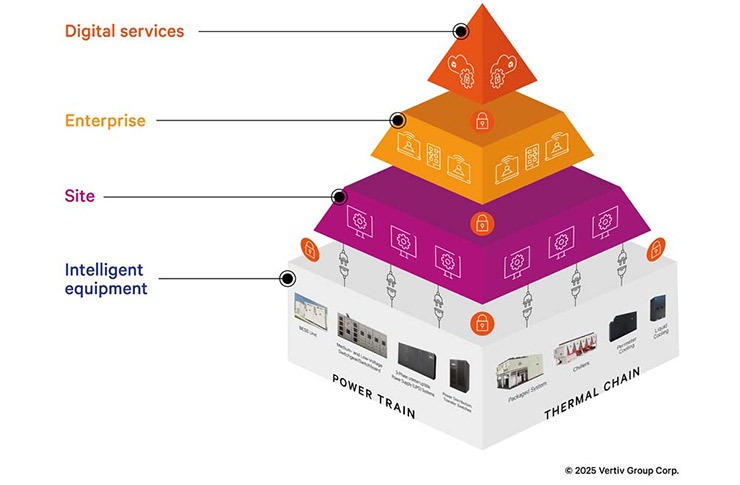

In ambienti ad alta densità e a ritmi sostenuti, la gestione separata di sistemi energetici e termici aggiunge complessità che rallentano i processi prima ancora che il sistema sia in funzione (Grafico 2). Durante le fasi di realizzazione, i sistemi frammentati richiedono fornitori, team di ingegneri e tempistiche di integrazione distinti. Ogni piattaforma ha una configurazione logica, un’interfaccia e requisiti di avviamento distinti.

Grafico 2. Vertiv Unify supporta una gestione energetica e termica coerente a livello di apparecchiatura, impianto e azienda

Una volta in funzione, le problematiche persistono. I team sono costretti a orientarsi tra molteplici strumenti per monitorare e rispondere alle criticità di performance, ognuno con struttura di dati, procedura di alert e tempistica di upgrade distinta. Ciò può comportare tempi di risposta più lenti, workflow incoerenti e una maggiore gestione manuale a discapito della replicabilità dei casi di successo tra le diverse sedi.

Alimentazione e raffreddamento, ripensati come un insieme integrato

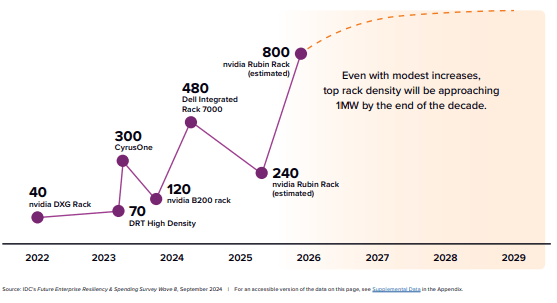

L’elaborazione accelerata e i workload dell’AI spingono i sistemi di alimentazione e termici a operare in modo integrato. Secondo IDC, i workload stimolano le densità a superare i 100 kW per rack, e si prevede che alcune implementazioni raggiungeranno o supereranno 1 MW entro la fine del decennio (Grafico 3) e, in queste condizioni, la gestione separata dei sistemi di alimentazione e raffreddamento introduce complessità che gli operatori non possono più permettersi.

Grafico 3. Le proiezioni sulla densità dei rack evidenziano la crescita dell’infrastruttura di AI, con densità di rack prossime a 1 MW entro il 2030. Fonte: IDC, 2025

Le infrastrutture di alimentazione e termiche integrate riducono la complessità di integrazioni personalizzate, le dipendenze dai fornitori e le configurazioni manuali. Una tecnologia predefinita integrata nel software consente ai team di standardizzare la gestione delle condizioni di salute delle apparecchiature, del consumo energetico e delle condizioni ambientali nei vari siti. I protocolli open semplificano le connessioni con i diversi fornitori di apparecchiature. L’integrazione di software e hardware a livello di impianto consente un’implementazione più rapida grazie a sistemi plug-and-play che semplificano il lavoro in loco, riducendo i tempi di messa in servizio e l’avvio stesso del sito.

A livello operativo, la sinergia semplifica il controllo e velocizza la risoluzione dei problemi. I team acquisiscono una visibilità maggiore con dati consolidati, avvisi coerenti e un minor numero di operazioni manuali. I problemi vengono individuati più rapidamente. Il processo decisionale diventa più semplice. Gli operatori possono gestire l’infrastruttura con sicurezza in tutti i siti, migliorando affidabilità ed efficienza.

La transizione verso un’infrastruttura flessibile

Con l’integrazione dell’AI nelle attività aziendali, i data center devono trasformarsi da ambienti reattivi in sistemi dinamici capaci di adattarsi alle nuove condizioni con velocità, precisione e intelligenza maggiori. Il cambiamento spinge verso un’infrastruttura unificata, in cui i sistemi di alimentazione e termici sono gestiti da un’unica piattaforma di controllo. IDC riporta che l’80% dei senior tech leader considera l’alimentazione e il raffreddamento centrali per le proprie strategie di AI. Tuttavia, la maggior parte dei data center non è stata progettata per la velocità o la variabilità dei workload di AI.

Per soddisfare le nuove esigenze non basta un nuovo hardware, ma servono sistemi integrati che semplifichino la progettazione e la variabilità dei workload dell’AI e si adattino alle eventuali riprogettazioni. Grazie al controllo centralizzato, gli operatori possono incrementare le capacità modulari, gestire le variazioni del consumo energetico e adottare sistemi di liquid cooling e di alimentazione avanzati.

In sintesi, l’alimentazione e il raffreddamento non viaggiano più su binari paralleli. Oggi fanno parte di un cambiamento globale verso un’infrastruttura integrata realizzata per ottenere velocità, scalabilità e controllo del data center.