La gestione dei dati non è mai stata così critica come è oggi, un momento in cui l’ecosistema tecnologico è in continua e rapida trasformazione. In questo scenario altamente dinamico, NetApp vuole consolidare il suo ruolo di innovatore dello storage con una serie di annunci consistenti e rivoluzionari volti a ridefinire l’approccio all’Intelligent Data Infrastructure.

L’obiettivo principale, come spiegato da Davide Marini, Country Manager NetApp Italia, è chiaro: “ascoltare i clienti, creare innovazione, investire per fornire soluzioni che possano aiutarli a risolvere i loro problemi o cogliere l’opportunità di vincere le sfide”.

La novità più significativa ruota attorno alla trasformazione dei dati nel contesto dell’intelligenza artificiale, dove il dato è l’elemento centrale di ogni evoluzione, che si tratti di cloud, modernizzazione infrastrutturale, cybersecurity o la stessa AI. In effetti, la criticità è alta: Gartner afferma che il 60% dei progetti AI viene abbandonato per un problema legato al fatto che i dati non sono AI ready, ovvero non sono pronti al momento giusto e non sono nemmeno nel posto giusto. Questa realtà smonta la convinzione errata secondo cui “troppe aziende pensano che mettersi in casa delle soluzioni Nvidia GPU particolarmente potenti sia il modo ideale per approcciare un oggetto di artificial intelligence”, mentre il problema critico resta, appunto, la prontezza del dato.

La rivoluzione dello storage disaggregato per l’AI

Il cuore di questa innovazione è il nuovo portfolio NetApp AFX, una soluzione progettata specificamente per affrontare i progetti di artificial intelligence in modo “sicuro, concreto ed efficace”, come sottolineato da Roberto Patano, Senior Manager System Engineering. Questa soluzione si compone di due elementi distinti: uno storage disaggregato e un nodo Data Engine, che insieme creano una piattaforma completa e performante.

L’elemento di rottura risiede nella disaggregazione delle due componenti fondamentali per l’AI: performance e capacità. Come ha precisato Davide Marini, l’innovazione risiede nel fatto che, “mentre nelle soluzioni precedenti esisteva un legame minimo ma necessario tra la parte computazionale e la parte storage, con AFX le due componenti sono state scollegate completamente”. Questo permette di scalare in maniera totalmente indipendente.

Roberto Patano ha specificato che è ora possibile aumentare unicamente la parte di performance aggiungendo nodi di storage o gestire in modo più semplice la crescita dei dati. Questa architettura, che opera su una versione disaggregata di NetApp ONTAP, può raggiungere 128 nodi di potenza controller e oltre 1 exabyte di capacità storage. Una soluzione che Nvidia ha già certificata da come Superpod e che include nella configurazione minima quattro controller computazionali e uno shelf dischi. Le componenti hardware includono l’AFX1K per il controller storage, l’NX224 per lo shelf dischi NVMe ad alte performance e il DX50 Data Compute Node.

Il DX50 non è solo un componente hardware, ma il vero motore della piattaforma, il Data Engine, che pre-elabora i dati e crea i metadati per renderli “il più facilmente accessibile a quelle che sono tutte quelle opzioni esterne di RAG piuttosto che LLM”, come ha precisato Patano. A riprova della partnership, il DX50 incorpora al suo interno le GPU L4 di NVIDIA.

I quattro pilastri software del data engine

Il Data Engine si articola in quattro pilastri software essenziali per rendere i dati realmente pronti per l’AI. Il primo è il Metadata Engine, che crea un metadato globale su tutte le informazioni, indipendentemente dalla loro residenza – che sia on-premise, cloud o software defined – consentendo un accesso in tempo reale estremamente semplice. Questo è un elemento cruciale, poiché serve a eliminare le informazioni ridondanti e ad assicurare che i dati siano sempre aggiornati all’ultima modifica.

Il secondo elemento è Data Sync, un motore basato sulla tecnologia NetApp SnapDiff che identifica in modo efficiente quali informazioni sono state modificate all’origine, anche su Edge. In questo modo, DataSync mantiene i metadati sempre aggiornati senza dover trasferire l’intero volume di dati, “abbattendo completamente i tempi di trasferimento delle informazioni”.

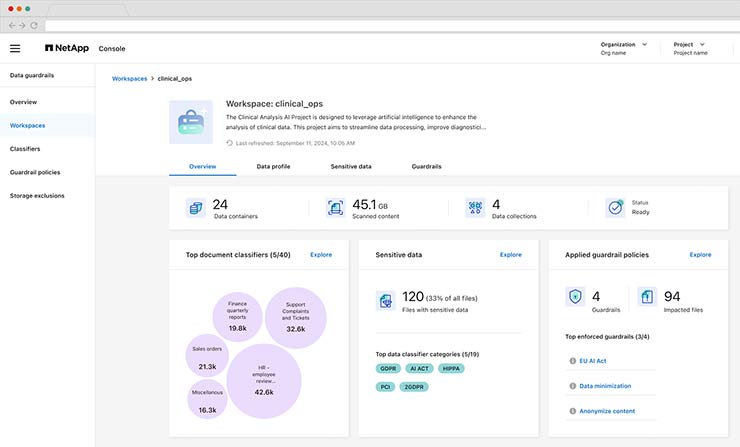

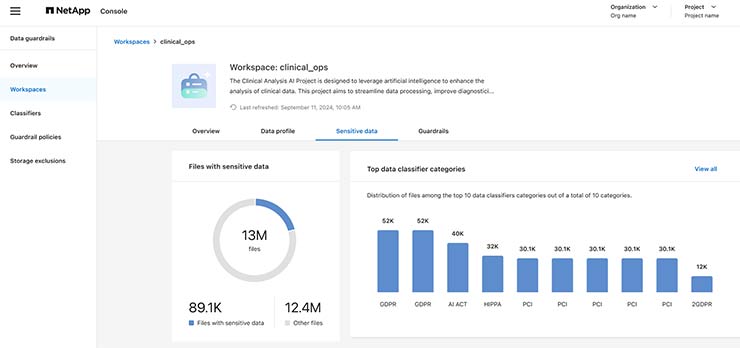

Il terzo pilastro è Data GuardRails, fondamentale per la sicurezza e la conoscenza delle informazioni. Questo servizio permette di effettuare una classificazione in ambiente multicloud per identificare i dati sensibili, garantendo la conformità con normative come il GDPR e consentendo di creare sottoinsiemi di dati anonimi per l’analisi predittiva. Roberto Patano ha ribadito un concetto chiave in questo ambito: “non è necessario solo avere le informazioni bisogna conoscerle e utilizzarle nella maniera corretta rimanendo conforme a quelle che possono essere le normative”.

Infine, il Data Curator integra un Vector Database direttamente nel Data Engine, consentendo l’accesso alle informazioni anche in maniera semantica. Questo modulo pre-elabora i dati per fornirli in modo sicuro attraverso API standard alle soluzioni esterne di Retrieval-Augmented Generation (RAG). NetApp mantiene così il suo ruolo di Data Management Company, concentrandosi sulla “gestione migliore in maniera sicura, multi-protocol, in ambienti multi-cloud delle informazioni”, accelerando quei processi di inferenza sui dati reali che stanno rallentando l’implementazione dell’AI in molti ambiti.

Sicurezza, resilienza e semplificazione operativa

La missione di NetApp è trattare l’AI con la stessa importanza e con la stessa accortezza dei workload Enterprise. Questo si traduce in un’infrastruttura con resilienza di grado enterprise, alta disponibilità e protezione da ransomware. Queto si traduce nell’introduzione di nuovi servizi all’interno di NetApp Console, rebrand di BlueXP. Oltre alla Autonomous Ransomware Protection integrata nello storage, l’azienda aggiunge funzionalità per prevenire l’esfiltrazione di informazioni. Questi nuovi modelli predittivi analizzano la fase di scrittura per identificare gli attacchi ransomware e, in modo inverso, la lettura per intercettare possibili attacchi di esfiltrazione. A completare il quadro, è stato introdotto un servizio che garantisce un ambiente isolato e testato per il recovery, assicurando la pulizia dei dati che sono disponibili nel caso di attacchi gravi. L’affidabilità di questa protezione è stata riconosciuta da SA Labs con il massimo rating, Tripla A.

In un’ottica di semplificazione e riduzione della complessità, è stato lanciato anche un servizio di Disaster Recovery che automatizza il processo on-prem su on-prem, cloud su on-prem e viceversa. Questo, unito alla versione as a service Keystone – che permette di fruire delle soluzioni in OpEx senza obbligo di acquisto – risponde alla missione di NetApp. Come riassunto da Marini, l’obiettivo è “rendere più semplice ridurre la complessità e ridurre i problemi dei clienti”, automatizzando per escludere problemi e far risparmiare tempo.

Apertura e integrazione in ambienti ibridi e multicloud

NetApp rafforza anche la sua posizione come unico vendor First Party Services con i principali hyperscaler (Google, Azure, Amazon), garantendo che le proprie tecnologie siano utilizzabili anche per le soluzioni AI più avanzate come Cloud Vertex di Google. Questo continuo riconoscimento da parte degli hyperscaler conferma che lo storage basato su ONTAP è la scelta di elezione per workload esigenti: lo dimostra l’integrazione con Google Cloud NetApp Solution, che ora supporta anche iSCSI per workload unificati, espandendo l’utilizzo per database e VM.

Infine, in un momento in cui le aziende cercano alternative alla virtualizzazione tradizionale, NetApp offre gratuitamente Shift Toolkit, uno strumento che permette di migrare macchine virtuali da VMware verso hypervisor come Hyper-V, Red Hat od Oracle in modo “totalmente non distruttivo” ha sottolineato Patano e con una rapidità sorprendente, “passando da giorni a minuti”.

In parallelo, Trident, il plugin gratuito per la containerizzazione, permette di utilizzare le funzionalità di NetApp in ambienti container, con una partnership di sviluppo attiva con Red Hat su OpenShift.

Roberto Patano ha concluso ribadendo che “Netapp sta portando tutta l’esperienza che ha sviluppato nell’arco dei trent’anni nell’ambito della vettorizzazione anche all’interno del mondo della containerizzazione”.