A dirlo sono i risultati della ricerca targata Columbia University e University of Chicago relativa alle email spam e basata sui dati di Barracuda Networks.

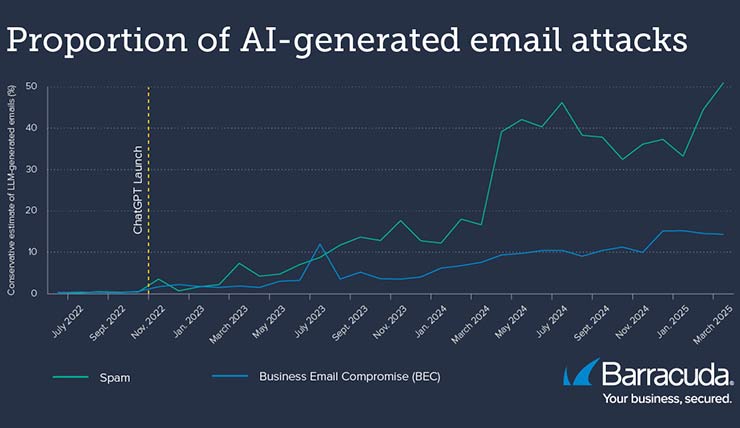

Secondo una nuova ricerca della Columbia University e della University of Chicago basata sui dati di rilevamento delle minacce di Barracuda Networks, i truffatori via e-mail utilizzano strumenti di intelligenza artificiale per creare e lanciare campagne di spam di massa piuttosto che attacchi mirati avanzati. I risultati mostrano che il 51% dei messaggi di spam è generato dall’AI, rispetto al 14% degli attacchi di compromissione dell’e-mail aziendale (le cosiddette truffe BEC). Benché l’uso dell’intelligenza artificiale sia in aumento in entrambi i casi.

I ricercatori hanno analizzato un ampio set di dati Barracuda contenente e-mail non richieste e malevole che coprono il periodo compreso tra febbraio 2022 e aprile 2025.

I risultati

- Ad aprile 2025, il 51% delle e-mail di spam risultava generato dall’intelligenza artificiale anziché da un essere umano.

- Ad aprile 2025, il 14% degli attacchi BEC risultava generato dall’intelligenza artificiale.

- Si è verificato un aumento costante dei contenuti generati dall’intelligenza artificiale. Questo sia nello spam sia nelle truffe BEC, dopo il lancio di ChatGPT nel novembre 2022.

- Le e-mail generate dall’AI sono in genere più formali. Utilizzano un linguaggio più sofisticato e presentano meno errori grammaticali rispetto a quelle scritte dall’uomo.

- Apparentemente gli aggressori utilizzano l’intelligenza artificiale per testare diverse scelte linguistiche. Questo serve per verificare quali sono più efficaci per eludere le difese e spingere un maggior numero di vittime a cliccare sui link.

- Gli aggressori sembrano servirsi dell’intelligenza artificiale principalmente per perfezionare il contenuto delle e-mail piuttosto che per modificare le tattiche offensive.

L’approccio utilizzato dai ricercatori per rilevare l’utilizzo dell’AI si è basato sull’ipotesi che le e-mail inviate prima del lancio pubblico di ChatGPT nel novembre 2022 fossero create con ogni probabilità da esseri umani. Questo ha permesso di avere un modello di riferimento. E di addestrare i rilevatori per identificare automaticamente se un’e-mail dannosa o non richiesta è stata generata utilizzando l’AI.

Per Barracuda, per difendersi dall’evoluzione delle minacce via e-mail è fondamentale implementare una protezione avanzata, multilivello e potenziata dall’intelligenza artificiale. Questo insieme alla formazione per sensibilizzare i dipendenti sulla cybersicurezza, in modo che conoscano le ultime tattiche di attacco e le minacce da tenere d’occhio.