L’acceleratore CortAIx di Thales ha sviluppato un metamodello che rileva immagini, video e audio generati dall’AI con fini di disinformazione, manipolazione e frode di identità. Con l’aumento dell’uso delle tecnologie AI, in un momento in cui la disinformazione sta diventando sempre più diffusa, il metamodello di rilevamento dei deepfake offre un modo per combattere la manipolazione delle immagini in molteplici casi, come la lotta contro le frodi di identità.

Previste importanti perdite finanziarie

Le immagini generate dall’intelligenza artificiale vengono create utilizzando piattaforme come Midjourney, Dall-E e Firefly. Alcuni studi hanno previsto che nel giro di pochi anni l’uso di deepfake per furti di identità e frodi potrebbe causare enormi perdite finanziarie. Gartner ha stimato che circa il 20% degli attacchi informatici nel 2023 ha probabilmente incluso contenuti deepfake nell’ambito di campagne di disinformazione e manipolazione. Il rapporto evidenzia il crescente uso dei deepfake nelle frodi finanziarie e negli attacchi di phishing.

Il metamodello più tecniche

Christophe Meyer, Senior Expert in AI e Cto di cortAIx

Il metamodello di rilevamento dei deepfake di Thales affronta il problema delle frodi di identità e delle tecniche di morphing. L’aggregazione di più metodi – reti neurali, rilevamento del rumore e analisi della frequenza spaziale – ci aiuta a proteggere meglio il crescente numero di soluzioni che richiedono controlli biometrici dell’identità. Si tratta di un notevole progresso tecnologico e di una testimonianza dell’esperienza dei ricercatori di AI di Thales.

Quali i modelli più utilizzati

Il metamodello di Thales utilizza tecniche di apprendimento automatico, alberi decisionali e valutazioni dei punti di forza e di debolezza di ciascun modello per analizzare l’autenticità di un’immagine. Combina vari modelli, tra cui:

il metodo CLIP (Contrastive Language-Image Pre-training) prevede il collegamento di immagine e testo attraverso l’apprendimento di rappresentazioni comuni. Per rilevare i deepfake, CLIP analizza le immagini e le confronta con le loro descrizioni testuali per identificare incongruenze e artefatti visivi.

Il metodo DNF (Diffusion Noise Feature) utilizza le attuali architetture di generazione di immagini (chiamate modelli di diffusione) per rilevare i deepfake. I modelli di diffusione si basano su una stima della quantità di rumore da aggiungere a un’immagine per causare una “allucinazione”, che crea contenuti dal nulla. Una stima che può essere utilizzata a sua volta per rilevare se un’immagine è stata generata dall’intelligenza artificiale.

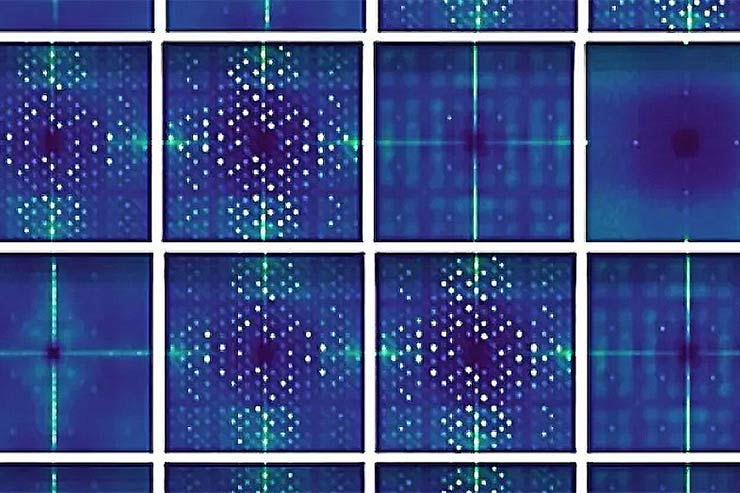

Il metodo DCT (Discrete Cosine Transform) per il rilevamento dei deepfake analizza le frequenze spaziali di un’immagine per individuare artefatti nascosti. Trasformando un’immagine dal dominio spaziale (pixel) al dominio della frequenza, è in grado di rilevare sottili anomalie nella struttura dell’immagine, che si verificano quando vengono generati deepfake e sono spesso invisibili a occhio nudo.

Anomalie difficilmente rilevabili : il ruolo del metamodello

Il gruppo di lavoro di Thales che c’è dietro questa invenzione fa parte di cortAIx, l’acceleratore di intelligenza artificiale del gruppo, che conta oltre 600 ricercatori e ingegneri. Di questi150 hanno sede presso il cluster di ricerca e tecnologia Saclay a Parigi e lavorano su sistemi mission-critical. Il team Friendly Hackers ha sviluppato la cassetta degli attrezzi BattleBox per aiutare a valutare la robustezza dei sistemi abilitati all’intelligenza artificiale.

Serve contro gli attacchi progettati per sfruttare le vulnerabilità intrinseche di diversi modelli di AI (inclusi i modelli linguistici di grandi dimensioni), come gli attacchi avversari e i tentativi di estrarre informazioni sensibili. Per contrastare questi attacchi, i ricercatori sviluppano contromisure avanzate come l’unlearning, l’apprendimento federato, la filigrana del modello e l’hardening del modello.